インストーラーのダウンロード

Download LM Studio - Mac, Linux, Windows

Discover, download, and run local LLMs

「Download for Windows」をクリック

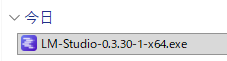

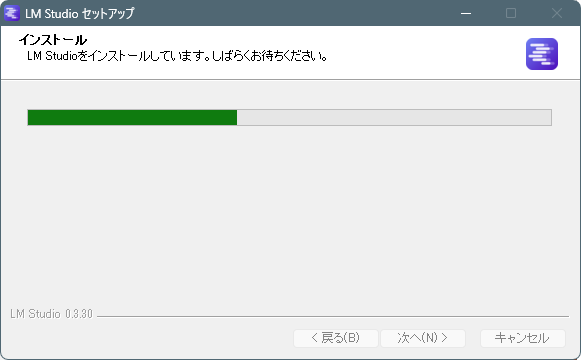

インストール

・ダウンロードしたファイル「LM-Studio-0.3.30-1-x64.exe」をエクスプローラでダブルクリック

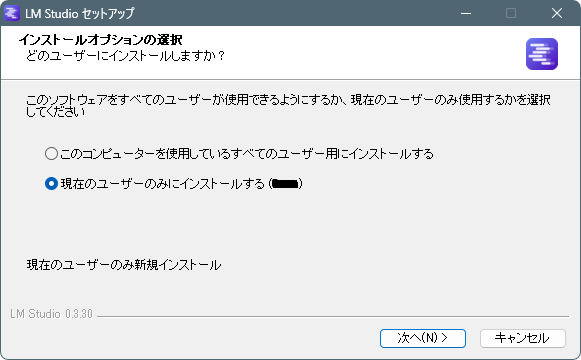

・実行ユーザーの選択(デフォルト)

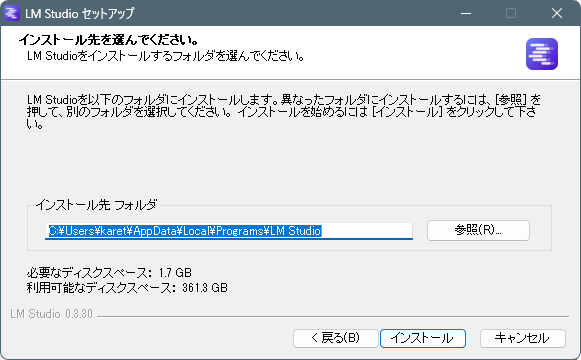

・インストール先のフォルダ(デフォルト)

・しばらく待つ

・セットアップウィザード完了

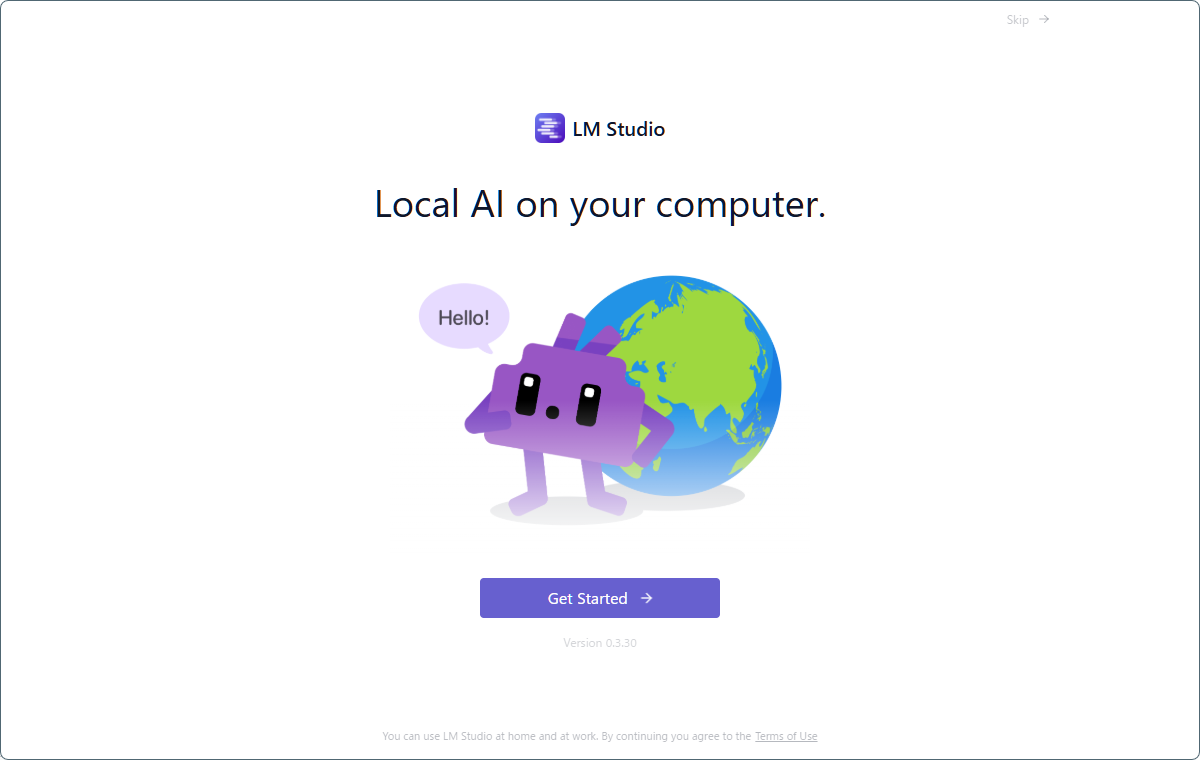

実行

・「Get Started」をクリック

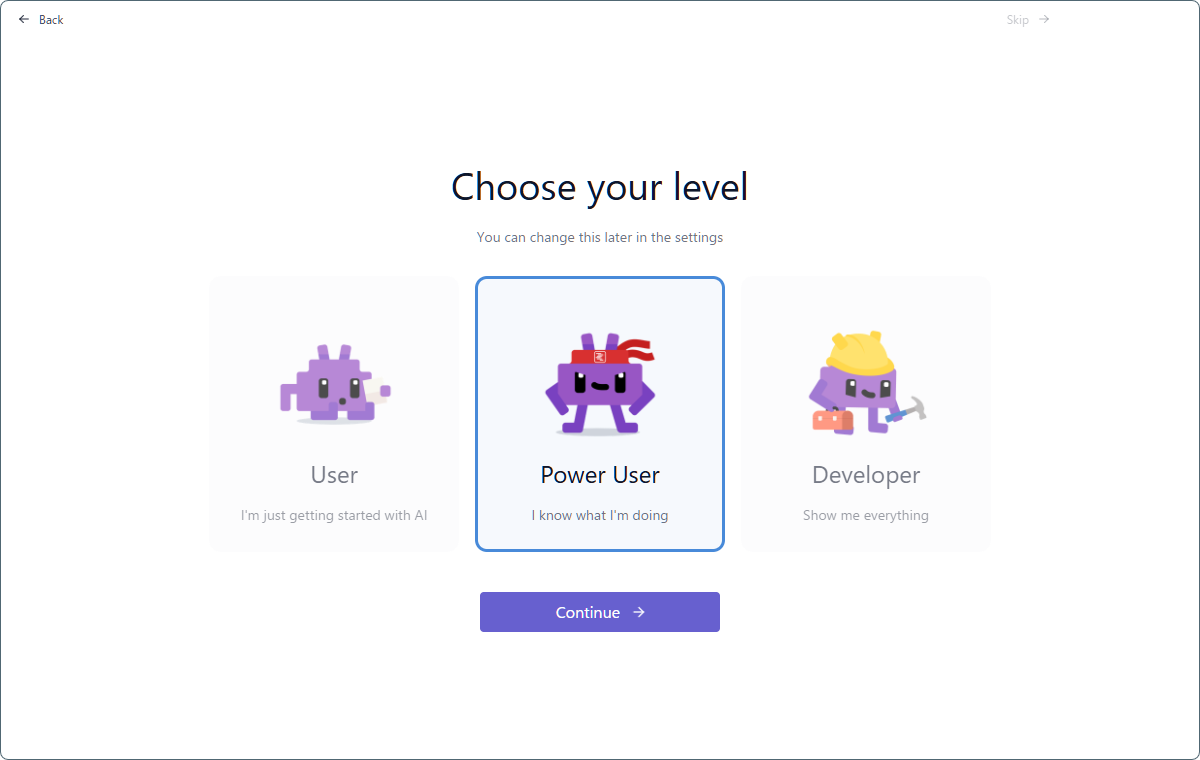

・「Power User」(デフォルト)

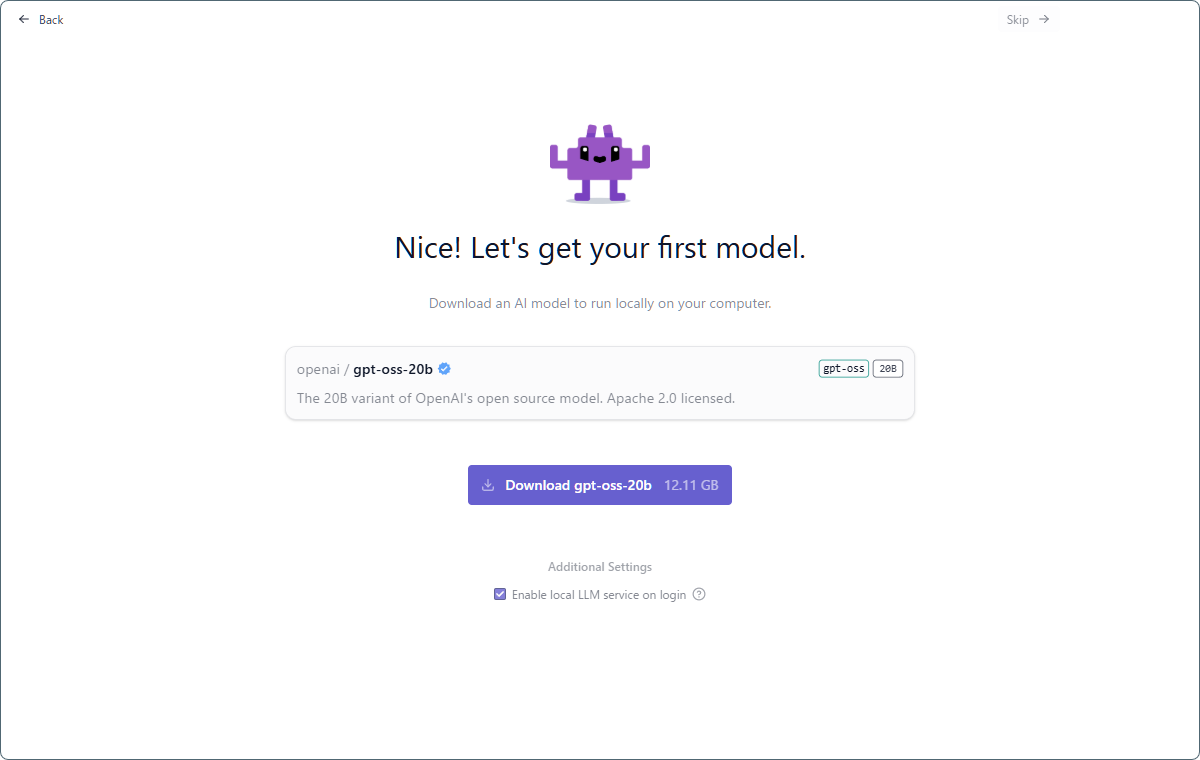

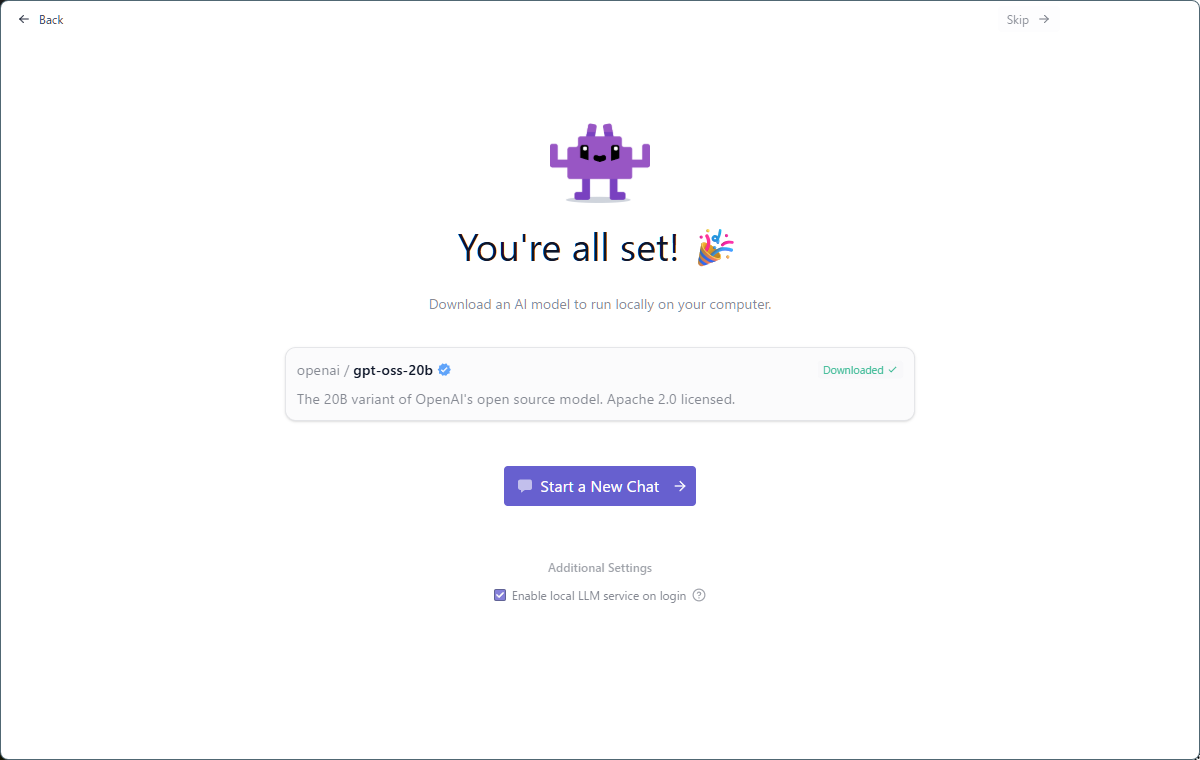

・モデルをダウンロード「gpt-oss-20b」

ダウンロード完了まで暫く待つ。

・「Start New Chat」をクリック

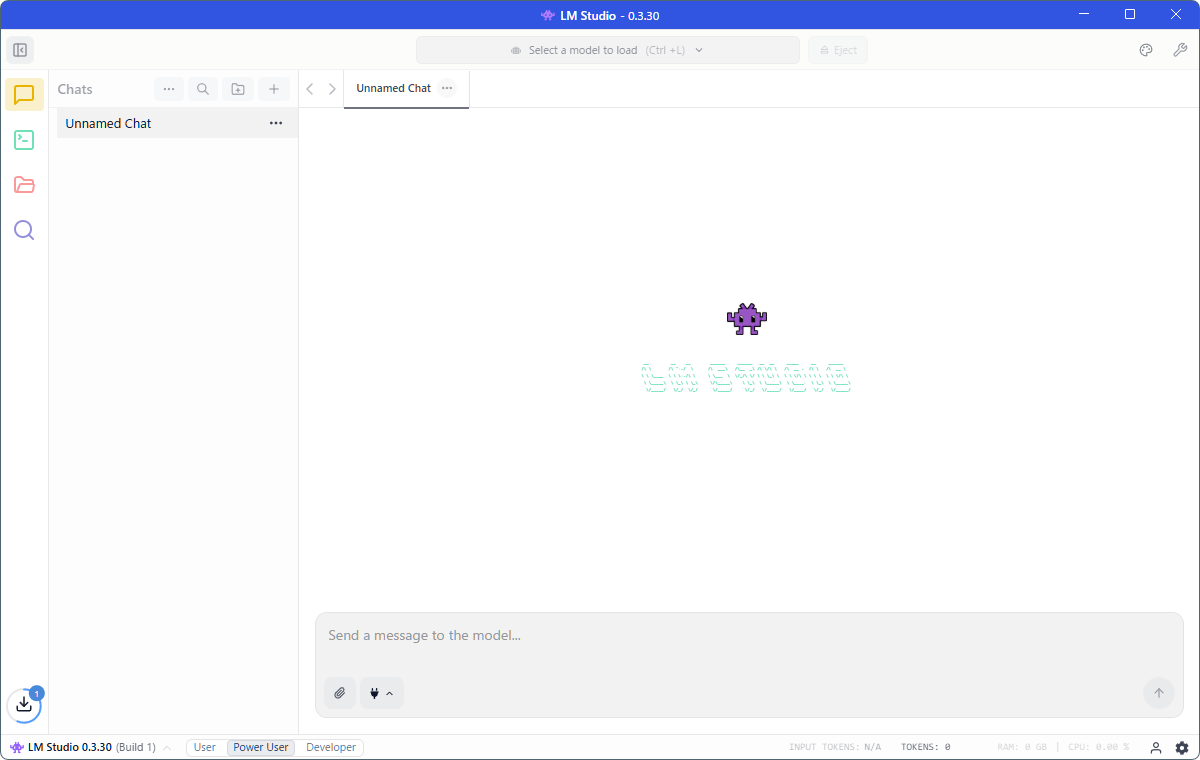

・チャット画面が起動します。

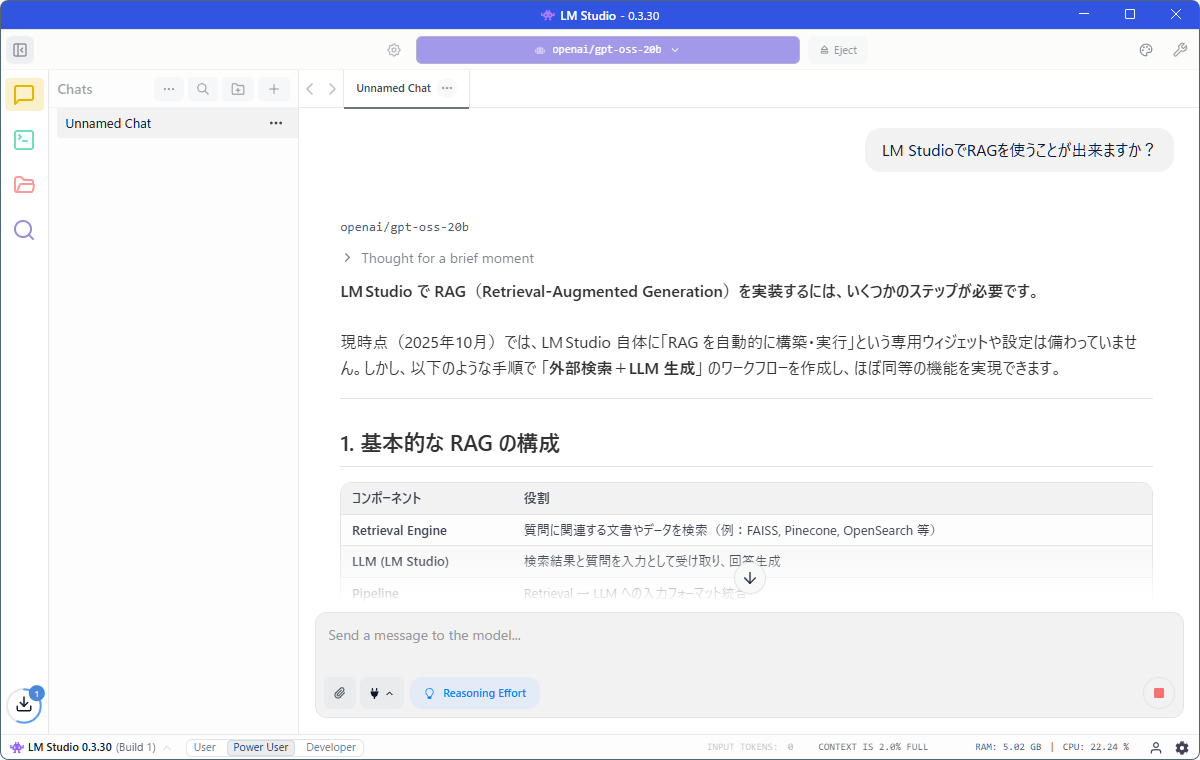

・モデルを選択しプロンプトを入力してみる。

日本語で入力したプロンプトに対し日本語で回答してくれました。

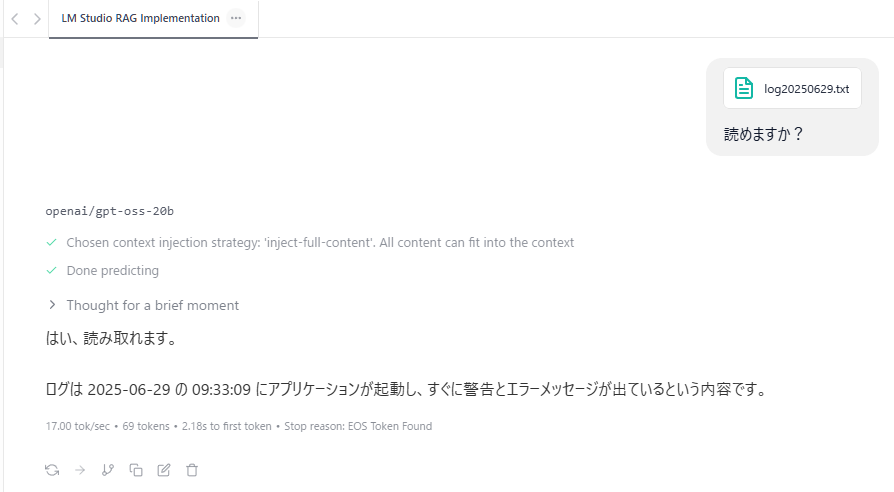

・ローカルストレージのTXTファイルを読み込ませてみる。

読み込めているようです。

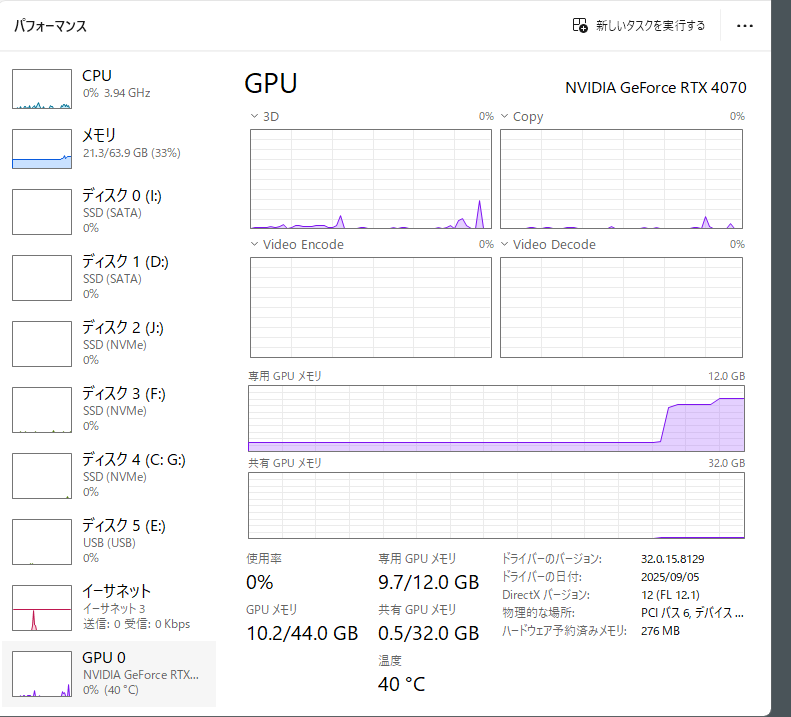

動作状況

・モデルを読み込むとVRAMが消費される。

VRAMの消費はモデルをイジェクトするまで続きます。

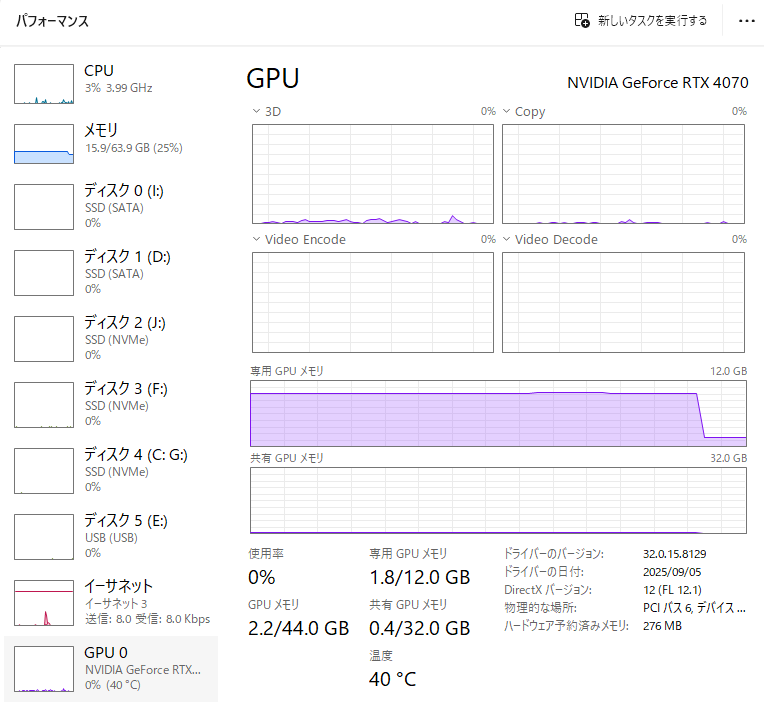

・モデルを胃弱とするとVRAMが解放される。

感想

とりあえずインストールして、最低限の動作チェックは出来ました。

インストール作業は特別難しいところは有りませんでした。

どんな使い道があるかは少しづつ試していきたいと思います。

コメント